ตรวจจับคลิปปลอมที่สร้างจาก AI ได้ด้วยการใช้ AI

Photo: SUNY

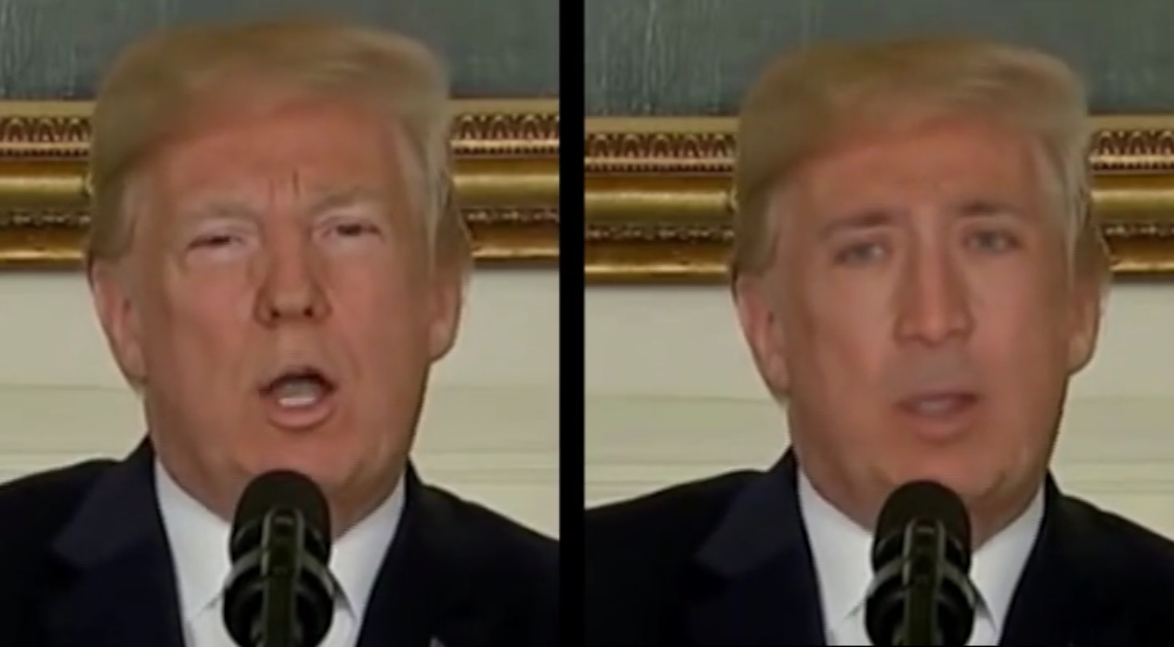

Photo: SUNYไม่ช่วงไม่กี่ปีที่ผ่านมา เรามักจะได้เห็นคลิปวิดีโอปลอม (Fake Video) เช่น คลิปหน้าคนดังพูดบางประโยค แต่ไม่ได้พูดประโยคนั้นจริงๆ ซึ่งคลิปนั้นสร้างมาจากเทคโนโลยีต่างๆ เช่น AI, Machine Learning หรือ Deep Learning ที่สลับเอาหน้าคนอื่นที่กำลังพูดประโยคหนึ่งให้มาอยู่ในใบหน้าคนดัง เทคนิคดังกล่าวเราเรียกว่า “Deepfake”

แต่ล่าสุดสำนักโครงการวิจัยขั้นสูงด้านกลาโหมสหรัฐ หรือ Defense Advanced Research Projects Agency (DARPA) ซึ่งเป็นหน่วยงานภายใต้กระทรวงกลาโหมของสหรัฐอเมริกา มีหน้าที่พัฒนาเทคโนโลยีใหม่สำหรับการใช้งานทางทหาร เปิดตัวโครงการที่ชื่อว่า 'Media Forensics' (การพิสูจน์หลักฐานในด้านมีเดีย) เพื่อต่อสู้กับ Deepfake แล้ว

Photo: University at Albany, SUNY

Photo: University at Albany, SUNYโดยโครงการนี้จะสร้างเครื่องมือตรวจจับวิดีโอที่ใช้เทคโนโลยี Deep Learning และ AI นั่นเอง โดยเทคนิคหนึ่งที่ใช้ในการตรวจจับความผิดปกติดังกล่าว ก็คือดวงตาของผู้พูดในคลิปนั้นก็ไม่ค่อยกะพริบตาบ่อยนัก นอกจากนี้ยังมีการออกเครื่องมือตรวจสอบอย่างอื่นออกมาด้วย เช่น การตรวจจับความผิดปกติของการเคลื่อนไหวศีรษะ หรือสีของดวงตาที่แปลกๆ เป็นต้น

เมื่อมีเครื่องมือพิสูจน์หลักฐานลักษณะดังกล่าวออกมา ถึงว่าเป็นจุดเริ่มต้นของการแข่งขันทางด้านอาวุธ AI ระหว่างระบบสร้างวีดีโอปลอมและนักสืบดิจิทัล ซึ่งในเวลานี้นักวิจัยที่พัฒนาระบบนี้ก็ยังไม่ได้เผยกลยุทธ์ทั้งหมดของระบบนี้ออกมา

“ตอนนี้เรามีความได้เปรียบเหนือระบบสร้างวีดีโออยู่เล็กน้อย และเราต้องการคงความได้เปรียบนี้ต่อไป” Siwei Lyu อาจารย์จาก University of Albany, SUNY หนึ่งในทีมนักวิจัยโครงการนี้กล่าว

อ้างอิงข้อมูลจาก MIT Technology Review

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด