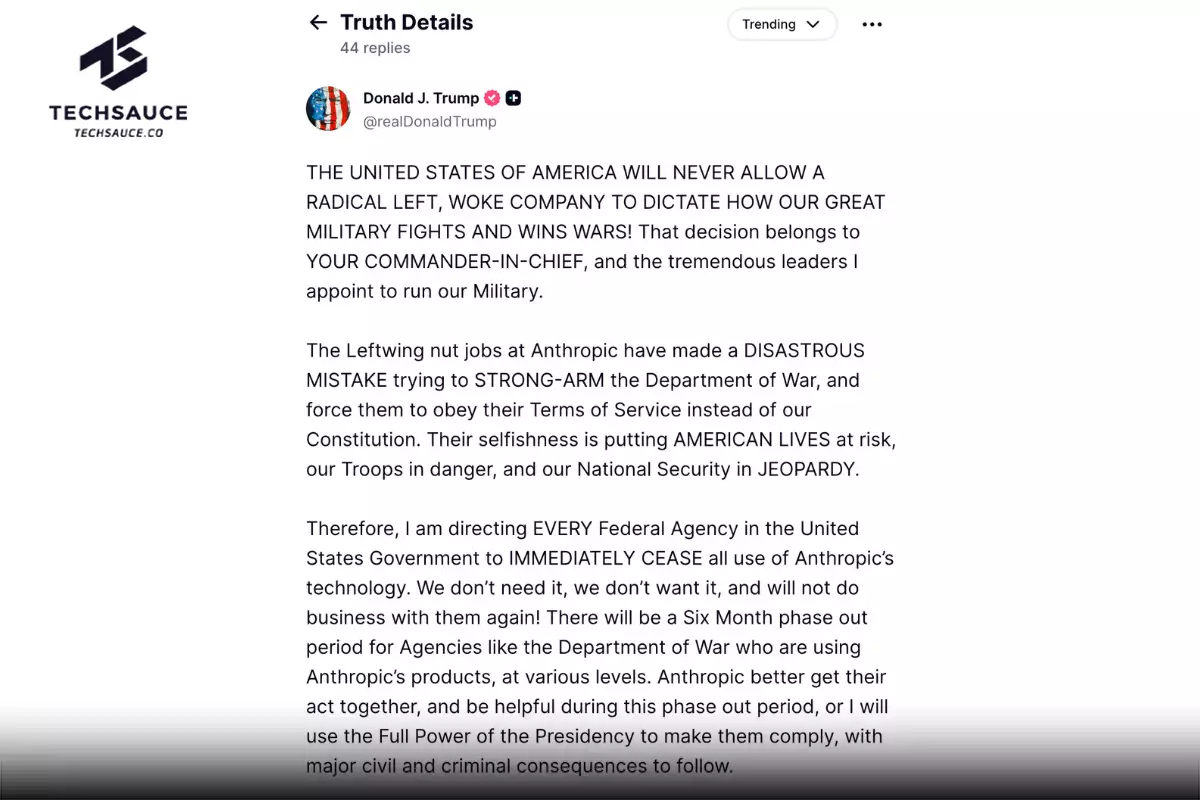

บริษัทญี่ปุ่นกังวลพนักงานใช้ ChatGPT ห่วงข้อมูลรั่ว เตรียมออกกฎป้องกัน

บริษัทญี่ปุ่นนำโดย SoftBank Hitachi ได้เริ่มตั้งกฎจำกัดการใช้งานเทคโนโลยี AI ที่สามารถโต้ตอบได้อย่างเช่น ChatGPT ในการดำเนินธุรกิจ ห่วงข้อมูลรั่วไหล สั่งห้ามพนักงานป้อนข้อมูลสำคัญ

ความนิยมของ ChatGPT ความน่าทึ่งในศักยภาพของมัน และมูลค่าทางธุรกิจในอนาคต ทำให้หลายบริษัทยักษ์ใหญ่ทั่วโลกโดยเฉพาะบริษัทเทคโนโลยีเริ่มนำ AI เข้ามาใช้ช่วยงาน ไม่ว่าจะเป็นการตอบข้อความ ร่างอีเมล สรุปประชุม และถามตอบข้อสงสัย อย่างไรก็ตามการใช้งานเทคโนโลยีนี้ยังคงทิ้งข้อกังวลไว้ให้ธุรกิจ โดยเฉพาะเรื่องข้อมูล ซึ่งล่าสุดบริษัทในญี่ปุ่นเริ่มขยับตัวออกมาตรการควบคุมป้องกัน

บริษัทญี่ปุ่นจำกัดการใช้งาน ChatGPT ห่วงข้อมูลรั่ว

เมื่อเดือนที่แล้ว SoftBank ได้เตือนพนักงานเกี่ยวกับการใช้งาน ChatGPT และแอปพลิเคชันทางธุรกิจอื่น ๆ โดยห้ามพนักงานป้อนข้อมูลที่เป็นความลับหรือข้อมูลใดๆ ที่จะระบุถึงบริษัท และหลังจากนี้บริษัทจะสร้างกฎระเบียบขึ้นมาระบุว่าภาคส่วนใดบ้างในองค์กรที่จะสามารถใช้เทคโนโลยีได้ รวมถึงระบุประเภทแอปพลิเคชันที่อนุญาตให้ใช้

ด้าน Hitachi พิจารณากำหนดกฎจริยธรรมใหม่สำหรับการใช้งาน AI แบบโต้ตอบ เช่นเดียวกับกลุ่มเทคโนโลยีของ Fujitsu ก็ได้เตือนพนักงานเกี่ยวกับการใช้งาน ChatGPT และบริการ AI อื่น ๆ ทั้งในแง่ของกฎหมาย จริยธรรม รวมถึงการปกป้องข้อมูล โดยมีการจัดตั้งหน่วยงานเพื่อตัดสินใจเกี่ยวกับการใช้ AI ด้วย

ในฟากธุรกิจธนาคาร Mizuho Financial Group, MUFG Bank และ Sumitomo Mitsui Banking ห้ามไม่ให้พนักงานใช้ ChatGPT และบริการอื่น ๆ ในการดำเนินงานเช่นเดียวกัน โดยฝั่ง Mizuho ถึงกับห้ามไม่ให้พนักงานเข้าถึงเว็บไซต์ ChatGPT จากอุปกรณ์บริษัทเพื่อป้องกันการรั่วไหลของข้อมูลสำคัญ เช่น ลูกค้าและธุรกรรมทางการเงิน ที่อาจเกิดจากการใช้งานอย่างไม่เหมาะสมของพนักงาน นอกจากนั้นยังมี NEC Corp. บริษัทเทคโนโลยีสารสนเทศที่ห้ามไม่ให้พนักงานใช้งานเช่นกัน

อีกด้านหนึ่ง Panasonic Connect บริษัทในเครือของ Panasonic ได้อนุญาตให้พนักงานใช้ AI ช่วยทำงานได้ โดยบริษัทได้ทำข้อตกลงกับ Microsoft ซึ่งเป็นผู้พัฒนาซอฟต์ว่าจะไม่ใช้เนื้อหาที่ป้อนลงไปสำหรับวัตถุประสงค์อื่น เช่น การฝึกอบรม AI นอกจากนั้นได้เตือนไม่ให้พนักงานป้อนข้อมูลส่วนตัวลงไปด้วย

การใช้งาน ChatGPT และความเสี่ยงที่ธุรกิจต้องรู้

วันที่ 1 มีนาคมที่ผ่านมา OpenAI ได้ปล่อยตัว API (Application programming interface) ของ ChatGPT ออกมา ทำให้บริษัทต่าง ๆ ที่อยากเอา ChatGPT ไปใช้ สามารถดึงไปรวมกับผลิตภัณฑ์บริการของตัวเองได้ แต่หากเลือกใช้บริการแบบไม่เสียค่าใช้จ่าย ข้อมูลที่ป้อนไประหว่างใช้งานจะถูกนำไปใช้เพื่อปรับปรุงประสิทธิภาพของตัวโมเดลได้ ซึ่งนี่เองอาจทำให้หลายบริษัทกังวล

Atsuhiro Goto ศาสตราจารย์จาก Institute of Information Security กล่าวว่า “Interactive AI ที่สามารถใช้งานได้ง่ายผ่านคอมพิวเตอร์ส่วนบุคคล (PC) ทำให้พนักงานระมัดระวังน้อยลง และมีความเสี่ยงที่ข้อมูลที่เป็นความลับอาจถูกบันทึกและนำไปใช้งานภายนอกบริษัทโดยไม่คาดคิด” เพราะฉะนั้นบริการนั้นก็ควรได้รับการตรวจสอบจากทีมงานภายในเพื่อระบุกฎการใช้งานและประเภทของข้อมูลที่นำไปใช้ได้เสียก่อน

อ้างอิง : Nikkei Asia

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด