ทลายกำแพงภาษา! Apple ปล่อยฟีเจอร์ Live Translation แปลสดทุกคำพูด ทุกข้อความ บน iOS 26

Apple ได้สร้างแรงสั่นสะเทือนให้กับวงการอีกครั้ง ด้วยการเปิดตัว Live Translation ฟีเจอร์ใหม่ล่าสุดใน iOS 26 ที่ขับเคลื่อนด้วย AI อัจฉริยะ “Apple Intelligence” โดยมีเป้าหมายเพื่อทลายกำแพงภาษาอย่างสมบูรณ์แบบ ทำให้การสื่อสารกับผู้คนทั่วโลกกลายเป็นเรื่องง่ายดายและเป็นส่วนตัวกว่าที่เคย

ไฮไลท์ที่สำคัญที่สุดและเป็นจุดเปลี่ยนที่ทำให้ Live Translation แตกต่างจากบริการแปลภาษาอื่นๆ คือ การประมวลผลทั้งหมดเกิดขึ้นบนตัวอุปกรณ์ (On-device AI) ดังนั้น ทุกการสนทนาไม่ว่าจะผ่านข้อความ, FaceTime, หรือการโทรศัพท์ จะยังคงรักษาความเป็นส่วนตัวของผู้ใช้งานไว้เป็นหลัก จะไม่มีข้อมูลใดถูกส่งออกไปประมวลผลบนเซิร์ฟเวอร์ภายนอก ซึ่งถือเป็นการตอกย้ำจุดยืนด้านความปลอดภัยและความเป็นส่วนตัวของผู้ใช้งานของ Apple อย่างชัดเจน

เจาะลึกการทำงาน Live Translation ของ Apple

Live Translation ถูกผสานเข้ากับแอปพลิเคชันสื่อสารหลักของ Apple เพื่อมอบประสบการณ์ที่ราบรื่นในทุกสถานการณ์ให้แก่ผู้ใช้งาน

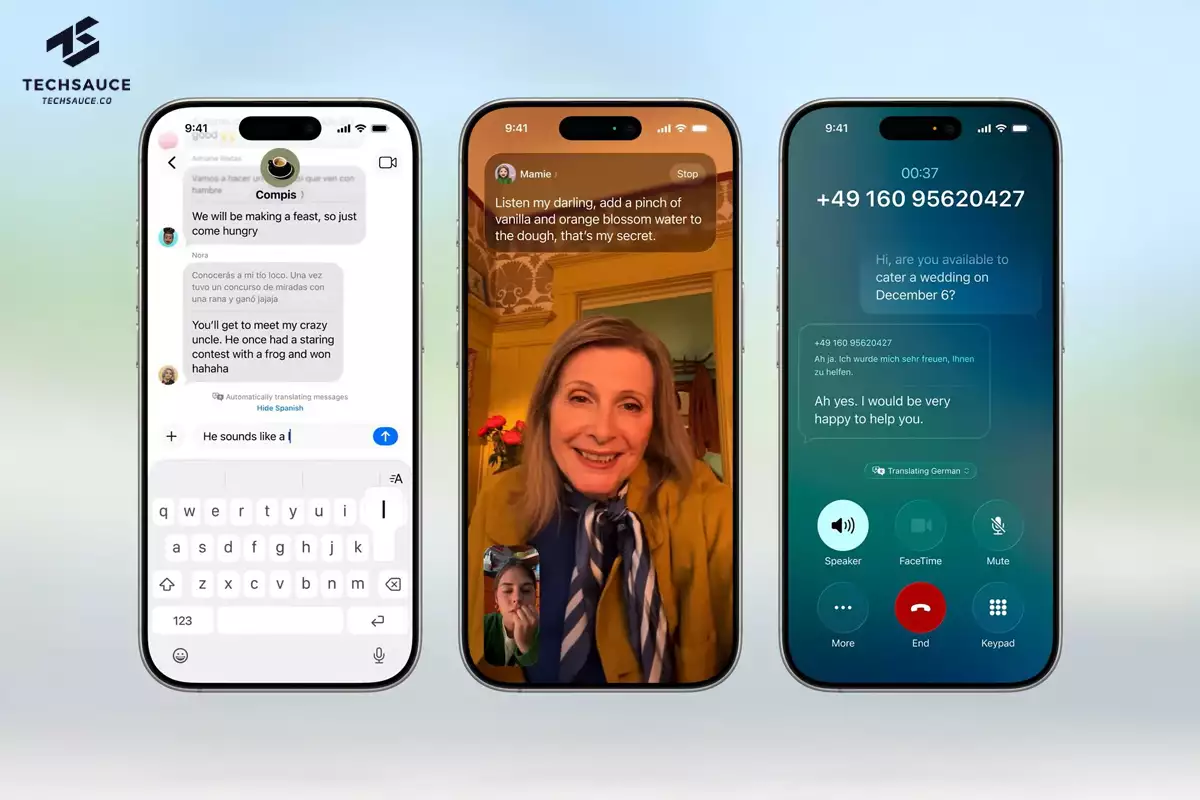

- Messages: แปลข้อความแชตแบบเรียลไทม์ เพียงแค่คุณพิมพ์ ข้อความจะถูกแปลเป็นภาษาปลายทางทันที และเมื่อมีข้อความตอบกลับ ก็จะถูกแปลกลับมาให้คุณโดยอัตโนมัติ ที่น่าสนใจคือฟีเจอร์นี้ ทำงานได้แม้ว่าคู่สนทนาจะไม่ได้ใช้ iPhone ก็ตาม

- FaceTime: สำหรับวิดีโอคอล จะแสดงผลในรูปแบบ คำบรรยายสดที่แปลแล้ว (Live Caption Translation) ทำให้คุณสามารถอ่านบทสนทนาที่แปลได้ทันที ควบคู่ไปกับการได้ยินเสียงต้นฉบับของผู้พูด

- Phone: ในการโทรศัพท์แบบเสียง ฟีเจอร์นี้จะทำหน้าที่เป็น ล่ามส่วนตัว (Spoken Translation) แปลคำพูดให้ทั้งสองฝ่ายตลอดการสนทนา

ไม่ได้จำกัดแค่การโทรและแชต: ต่อยอดสู่แอปอื่นและนักพัฒนา

ศักยภาพของ Live Translation ไม่ได้หยุดอยู่แค่แอปสื่อสารเท่านั้น แต่ยังถูกนำไปใช้ในแอปพลิเคชันอื่น เช่น Apple Music ที่จะมาพร้อมกับการแปลเนื้อเพลงแบบสดๆ และฟีเจอร์ช่วยออกเสียง

นอกจากนี้ Apple ยังเปิดกว้างให้นักพัฒนาสามารถนำความสามารถนี้ไปต่อยอดในแอปพลิเคชันของตนเองได้ผ่าน Call Translation API ซึ่งจะช่วยขยายขีดความสามารถในการสื่อสารไร้พรมแดนออกไปในวงกว้างยิ่งขึ้น

ภาษาที่รองรับในช่วงเปิดตัว

- Messages: อังกฤษ (สหรัฐฯ, สหราชอาณาจักร), ฝรั่งเศส, เยอรมัน, อิตาลี, ญี่ปุ่น, เกาหลี, โปรตุเกส (บราซิล), สเปน, และจีน (ตัวย่อ)

- Phone & FaceTime: อังกฤษ (สหรัฐฯ, สหราชอาณาจักร), ฝรั่งเศส, เยอรมัน, โปรตุเกส (บราซิล), และสเปน

Apple มีแผนที่จะเพิ่มการรองรับภาษาอื่นๆ ภายในสิ้นปีนี้ เช่น เดนมาร์ก, ดัตช์, นอร์เวย์, สวีเดน, ตุรกี, จีน (ตัวเต็ม), และเวียดนาม

ใครจะได้ใช้บ้าง? เช็กอุปกรณ์และกำหนดการเปิดตัว

ฟีเจอร์ Live Translation และความสามารถอื่นๆ ของ Apple Intelligence จะรองรับบนอุปกรณ์ต่อไปนี้:

- iPhone 16 ทุกรุ่น

- iPhone 15 Pro, iPhone 15 Pro Max

- iPad และ Mac ที่ใช้ชิป M1 หรือใหม่กว่า

โดยจะเริ่มเปิดให้นักพัฒนาทดสอบผ่าน Apple Developer Program แล้ววันนี้ ตามด้วย Public Beta ในเดือนหน้า และคาดว่าจะเปิดให้ใช้งานอย่างเป็นทางการพร้อมกับ iOS 26 ในช่วง ฤดูใบไม้ร่วง (ประมาณเดือนกันยายน-พฤศจิกายน) นี้ อย่างไรก็ตาม ฟีเจอร์บางอย่างอาจยังไม่พร้อมใช้งานในทุกภาษาหรือทุกภูมิภาค ขึ้นอยู่กับข้อกำหนดและกฎหมายของแต่ละประเทศ

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด