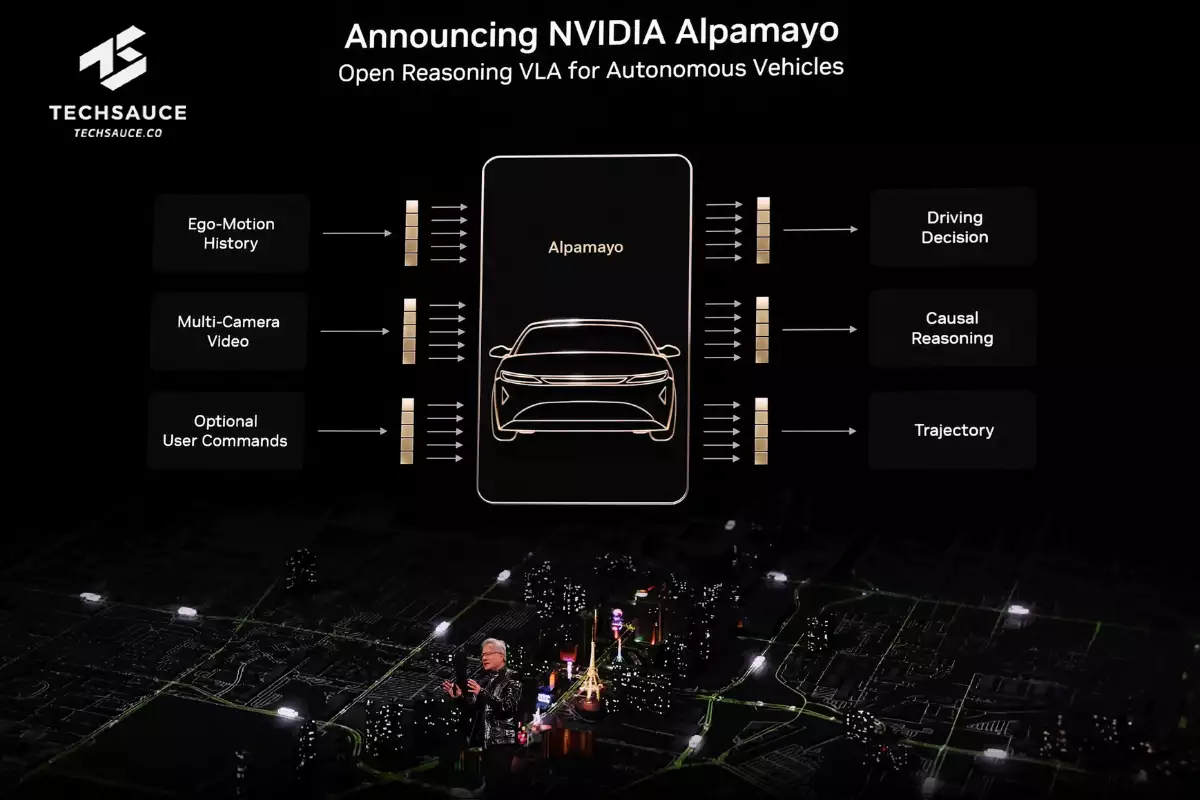

NVIDIA เผยโฉม ‘Alpamayo’ AI Open-source สำหรับรถไร้คนขับ โมเดลที่คิดและให้เหตุผลได้เหมือนมนุษย์

บนเวที CES 2026 ปีนี้ NVIDIA ได้สร้างแรงสั่นสะเทือนให้กับวงการยานยนต์และปัญญาประดิษฐ์อีกครั้ง ด้วยการเปิดตัว ‘NVIDIA Alpamayo’ ตระกูลโมเดล AI แบบ Open-source รวมถึงเครื่องมือจำลองสถานการณ์และชุดข้อมูลขนาดใหญ่ ที่ออกแบบมาเพื่อปฏิวัติวงการรถยนต์ไร้คนขับ (Autonomous Vehicle - AV) ให้ก้าวข้ามขีดจำกัดเดิมๆ สู่ความปลอดภัยและการคิดวิเคราะห์ที่ล้ำลึกยิ่งขึ้น

นี่ไม่ใช่แค่การอัปเดตซอฟต์แวร์ทั่วไป แต่คือการนำเสนอสถาปัตยกรรมใหม่ที่ NVIDIA เคลมว่า จะทำให้รถยนต์สามารถ ‘รับรู้ ให้เหตุผล และตัดสินใจ’ ได้ด้วยวิจารณญาณที่ใกล้เคียงกับมนุษย์มากที่สุด

Jensen Huang ซีอีโอและผู้ก่อตั้ง NVIDIA กล่าวถึงการเปิดตัวครั้งนี้ด้วยประโยคที่น่าจับตามองว่า ‘นี่คือช่วงเวลา ChatGPT moment สำหรับ Physical AI ช่วงเวลาที่เครื่องจักรเริ่มที่จะเข้าใจ ให้เหตุผล และกระทำสิ่งต่างๆ ในโลกแห่งความเป็นจริงได้’

เขาขยายความต่อว่า ‘Robotaxi จะเป็นกลุ่มแรกที่ได้รับประโยชน์ Alpamayo จะนำความสามารถในการให้เหตุผลมาสู่รถยนต์ไร้คนขับ ช่วยให้พวกมันสามารถคิดวิเคราะห์ผ่านสถานการณ์ที่เกิดขึ้นได้ยาก ขับขี่อย่างปลอดภัยในสภาพแวดล้อมที่ซับซ้อน และที่สำคัญคือสามารถอธิบายเหตุผลของการตัดสินใจขับขี่นั้นๆ ได้ นี่คือรากฐานของระบบอัตโนมัติที่ปลอดภัยและขยายผลได้จริง’

แก้โจทย์ยากด้วย ‘Chain-of-Thought’ Reasoning

ความท้าทายที่ใหญ่ที่สุดของรถยนต์ไร้คนขับคือสิ่งที่เรียกว่า ‘Long-tail’ หรือสถานการณ์ที่เกิดขึ้นได้ยาก มีความซับซ้อน และคาดเดาไม่ได้ (เช่น อุบัติเหตุแปลกๆ สภาพถนนที่ผิดปกติสุดขั้ว) ซึ่งสถาปัตยกรรม AV แบบดั้งเดิมที่แยกส่วนการรับรู้ออกจากการวางแผน ซึ่งมักจะไปต่อไม่ถูกเมื่อเจอสถานการณ์ที่ไม่เคยถูกโปรแกรมไว้ แม้เทคโนโลยี End-to-end learning จะช่วยได้ในระดับหนึ่ง แต่ NVIDIA มองว่าคำตอบที่แท้จริงคือโมเดลที่สามารถ ‘ให้เหตุผลถึงต้นเหตุและผลลัพธ์’

Alpamayo จึงนำเสนอโมเดล VLA (Vision Language Action) ที่ใช้กระบวนการคิดแบบ Chain-of-thought หรือการคิดเป็นลำดับขั้นตอน สิ่งนี้ช่วยให้ระบบ AI สามารถไตร่ตรองสถานการณ์ใหม่ๆ ทีละขั้น ปรับปรุงความสามารถในการขับขี่ และเพิ่มความสามารถในการอธิบาย ซึ่งเป็นกุญแจสำคัญในการสร้างความไว้เนื้อเชื่อใจในความปลอดภัย

เจาะลึก 3 Ecosystem แบบเปิด

NVIDIA ไม่ได้มาแค่โมเดลเดียว แต่มาพร้อมระบบนิเวศที่ครบวงจรเพื่อให้นักพัฒนาและทีมวิจัยทั่วโลกนำไปต่อยอดได้ทันที ได้แก่

Alpamayo 1

สมองกลที่คิดเป็นภาพและภาษา นี่คือโมเดล VLA แบบ Chain-of-thought รุ่นแรกของอุตสาหกรรมสำหรับงานวิจัย AV เปิดให้ดาวน์โหลดแล้วบน Hugging Face ด้วยสถาปัตยกรรมขนาด 1 หมื่นล้านพารามิเตอร์ Alpamayo 1 สามารถรับอินพุตเป็นวิดีโอและสร้างเส้นทางการขับขี่ออกมา พร้อมกับ ‘ร่องรอยการให้เหตุผล’ (Reasoning traces) ที่แสดงตรรกะเบื้องหลังการตัดสินใจในแต่ละช็อต นักพัฒนาสามารถนำไปปรับแต่ง หรือย่อส่วนเพื่อใช้ในรถยนต์จริง หรือใช้เป็นเครื่องมือตรวจสอบความถูกต้องก็ได้

AlpaSim

สนามทดสอบเสมือนจริงแบบ Open-Source เฟรมเวิร์กการจำลองแบบ End-to-end ที่เปิดเผยซอร์สโค้ดทั้งหมดบน GitHub ช่วยให้การพัฒนา AV มีความสมจริงขั้นสูง (High-fidelity) รองรับการจำลองเซนเซอร์ที่แม่นยำ การปรับตั้งค่าการจราจร และสภาพแวดล้อมการทดสอบแบบ Closed-loop ที่ขยายขนาดได้ เพื่อการตรวจสอบและปรับนโยบายการขับขี่ที่รวดเร็ว

Physical AI Open Datasets

คลังข้อมูลมหาศาล NVIDIA มอบชุดข้อมูลแบบเปิดที่มีความหลากหลายมากที่สุด รวมระยะเวลาการขับขี่กว่า 1,700 ชั่วโมง ครอบคลุมภูมิประเทศและสภาพเงื่อนไขที่กว้างขวางที่สุด รวมถึงเคสหายากที่จำเป็นอย่างยิ่งสำหรับการฝึกฝนโมเดลสาย Reasoning

การเปิดตัวครั้งนี้ได้รับความสนใจจากยักษ์ใหญ่ในวงการยานยนต์อย่างล้นหลาม ไม่ว่าจะเป็น Lucid, JLR (Jaguar Land Rover), Uber และสถาบันวิจัยอย่าง Berkeley DeepDrive

Thomas Müller ผู้บริหารจาก JLR ให้ความเห็นว่า ‘การพัฒนา AI ที่เปิดกว้างและโปร่งใสเป็นสิ่งจำเป็น การที่ NVIDIA เปิด Open-source โมเดลอย่าง Alpamayo ช่วยเร่งนวัตกรรมในระบบนิเวศการขับขี่อัตโนมัติ มอบเครื่องมือใหม่ๆ ให้นักพัฒนาจัดการกับสถานการณ์โลกจริงที่ซับซ้อนได้อย่างปลอดภัย’

ในขณะที่ฝั่ง Uber โดย Sarfraz Maredia มองว่า ‘การจัดการกับสถานการณ์ขับขี่แบบ Long-tail ที่คาดเดาไม่ได้ คือหนึ่งในความท้าทายที่นิยามความเป็นระบบอัตโนมัติ Alpamayo สร้างโอกาสใหม่ที่น่าตื่นเต้นในการเร่งเครื่อง Physical AI และเพิ่มความโปร่งใสสำหรับการปล่อยรถระดับ Level 4 สู่ตลาด’

นอกเหนือจาก Alpamayo นักพัฒนายังสามารถเชื่อมต่อกับคลังเครื่องมือของ NVIDIA อย่างแพลตฟอร์ม NVIDIA Cosmos และ Omniverse เพื่อปรับแต่งโมเดลด้วยข้อมูลเฉพาะของตนเอง และนำไปใช้งานบนสถาปัตยกรรม NVIDIA DRIVE Hyperion ที่ขับเคลื่อนด้วยชิป NVIDIA DRIVE AGX Thor

การเปิดกว้างของ NVIDIA ในครั้งนี้ ไม่ใช่แค่การแจกของฟรี แต่คือการวางมาตรฐานใหม่ให้โลกเห็นว่า ‘รถยนต์ที่ขับตัวเองได้’ ไม่ใช่แค่เรื่องของการมองเห็น แต่เป็นเรื่องของการคิดและ‘ความเข้าใจโลกอย่างแท้จริง

ที่มา: NVIDIA, TechCrunch

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด