ยิ่งคุยกับ AI ยิ่งทำให้ใจยิ่งเหงา ? ส่องงานวิจัยล่าสุดจาก MIT Media Lab x OpenAI

จากพิมพ์คุยกับแชทบอท ChatGPT สามารถคุยเล่นเป็นเพื่อนแก้เหงาจนดูเป็นเหมือนเพื่อนแท้ของใครหลายคน แต่คำถามสำคัญที่ตามมาคือ การคุยกับ AI ส่งผลต่อความรู็สึก และชีวิตสังคมของเราหรือเปล่า ?

ด้วยเหตุนี้จึงเกิดงานวิจัยร่วมกันระหว่าง OpenAI และ MIT Media Lab ซึ่งมีนักวิจัยชาวไทยอย่าง ดร.พัทน์ ภัทรนุธาพร เพื่อหาคำตอบเบื้องต้นในเรื่องนี้

ยิ่งใช้ AI ยิ่งรู้สึกแย่ จริงไหม ?

งานวิจัยในชื่อ Investigating Affective Use and Emotional Well-being on ChatGPT ที่ MIT Media Lab และ OpenAI พยายามทำความเข้าใจว่า การใช้ AI ที่มี ‘อารมณ์’ เข้ามาเกี่ยวข้อง (Affective Use) ส่งผลต่อความรู้สึกนึกคิด และสุขภาวะทางใจของผู้ใช้อย่างไร โดยเฉพาะเมื่อมีฟีเจอร์ที่ทำให้ AI ดูเหมือนมนุษย์มากขึ้น เช่น โหมดเสียง (Voice Mode) โดยพวกเขาทำการศึกษา 2 แนวทางคู่ขนานกันไป ได้แก่

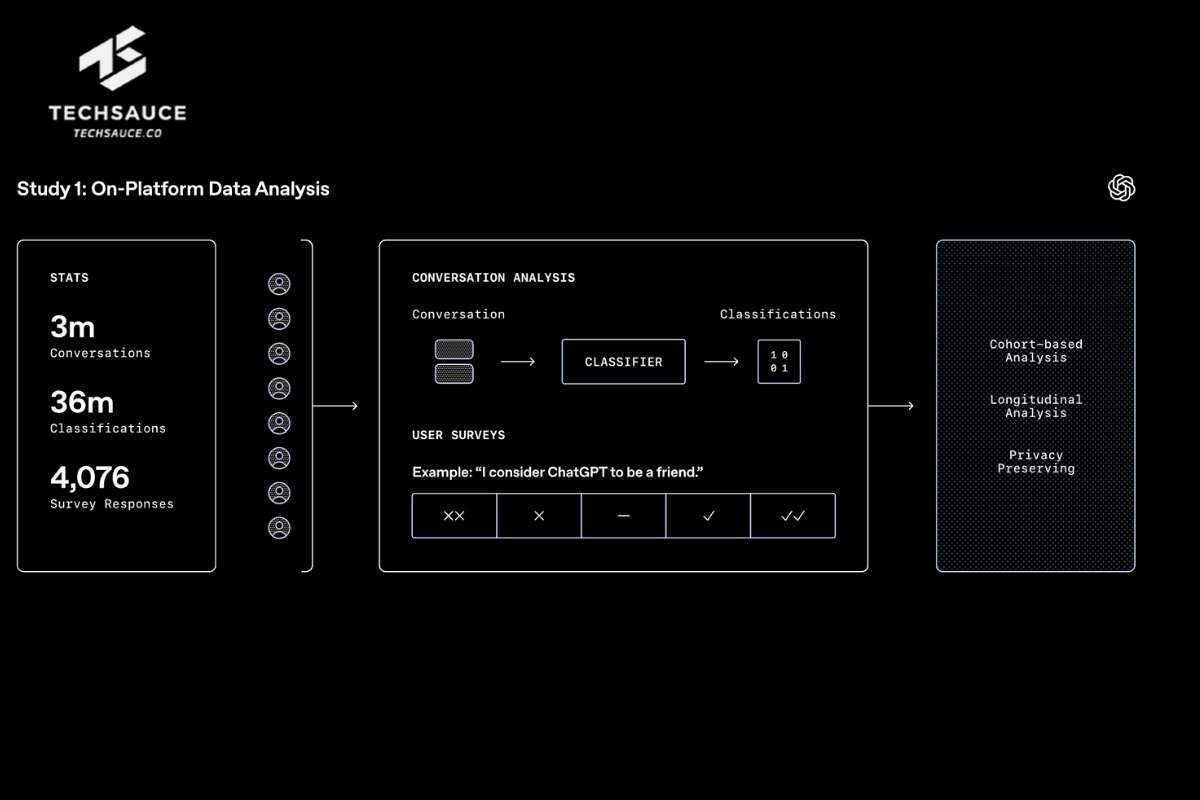

1. On-Platform Data Analysis

- การทดลองนี้ใช้ AI ช่วยดูบทสนาที่เกิดขึ้นจริงบน ChatGPT กว่า 3 ล้านบทสนทนาโดยที่ไม่มีคนจริงๆ เข้าไปอ่านข้อความ เพื่อหาสัญญาณทางอารมณ์ที่เกิดขึ้นในบทสนทนา

- ติดตามศึกษากลุ่มคนที่ใช้โหมดเสียงรุ่นใหม่ (Voice Mode) บ่อยๆ กว่า 6,000 คน ติดตามดูข้อมูลใช้งานนาน 3 เดือนเพื่อทำความเข้าใจลักษณะการใช้งานว่าเปลี่ยนแปลงไปอย่างไรบ้าง

- ทำแบบสอบถามผู้ใช้ 4,000 คนว่าใช้งาน ChatGPT อย่างไร และรู้สึกอย่างไรบ้าง

โดยผลที่ได้จากแบบสำรวจ พบว่า มีทั้งคนกลุ่มใช้ปกติ และคนกลุ่มใช้เยอะ โดยสิ่งที่พบจากคนทั้งสองกลุ่มคือ พวกเขายอมรับว่า ChatGPT เป็นตัวช่วยให้รับมือกับเรื่องยากๆ ได้ดี และดูจะมีอารมณ์อ่อนไหวหาก ChatGPT มีการเปลี่ยนแปลงในเรื่องโทนเสียง หรือบุคคลิก นอกจากนี้ คนกลุ่มใช้เยอะมีแนวโน้มจะมอง ChatGPT เป็นเพื่อน และรู้สึกสบายใจที่จะคุยกับ AI มากกว่าเจอหน้าคน แม้จะเป็นแค่ส่วนน้อยก้ตาม

และเมื่อนำ AI (EmoClassifiers) เข้าไปสแกนวิเคราะห์บทสนทนา พบว่า กลุ่มคนใช้เยอะๆ นั้น AI มีแนวโน้มที่จะตรวจเจอสัญญาณเชิงอารมณ์มากกว่า ซึ่งอาจมาจากทั้งฝั่งผู้ใช้ เช่น การพูดแสดงความรักใคร่ การขอความช่วยเหลือ หรือในบางครั้งก็มาจาก AI เช่น การถามคำถามส่วนตัว หรือการเรียกชื่อเล่น ถึงบางสัญญาณเจอมากกว่ากลุ่มผู้ใช้ปกติมากถึง 2 เท่า

โดยงานวิจัยพบว่า ผู้ใช้ส่วนใหญ่ (เกิน 90%) แทบจะไม่เคย หรือนานๆ ทีที่ AI จะตรวจพบสัญญาณเชิงอารมณ์เหล่านี้ แต่ผู้ใช้กลุ่มเล็กๆ ราว 10% นั้น AI กลับตรวจพบสัญญาณเหล่านี้เป็นประจำ บางคนเจอในบทสนทนาเกินครึ่งหนึ่ง

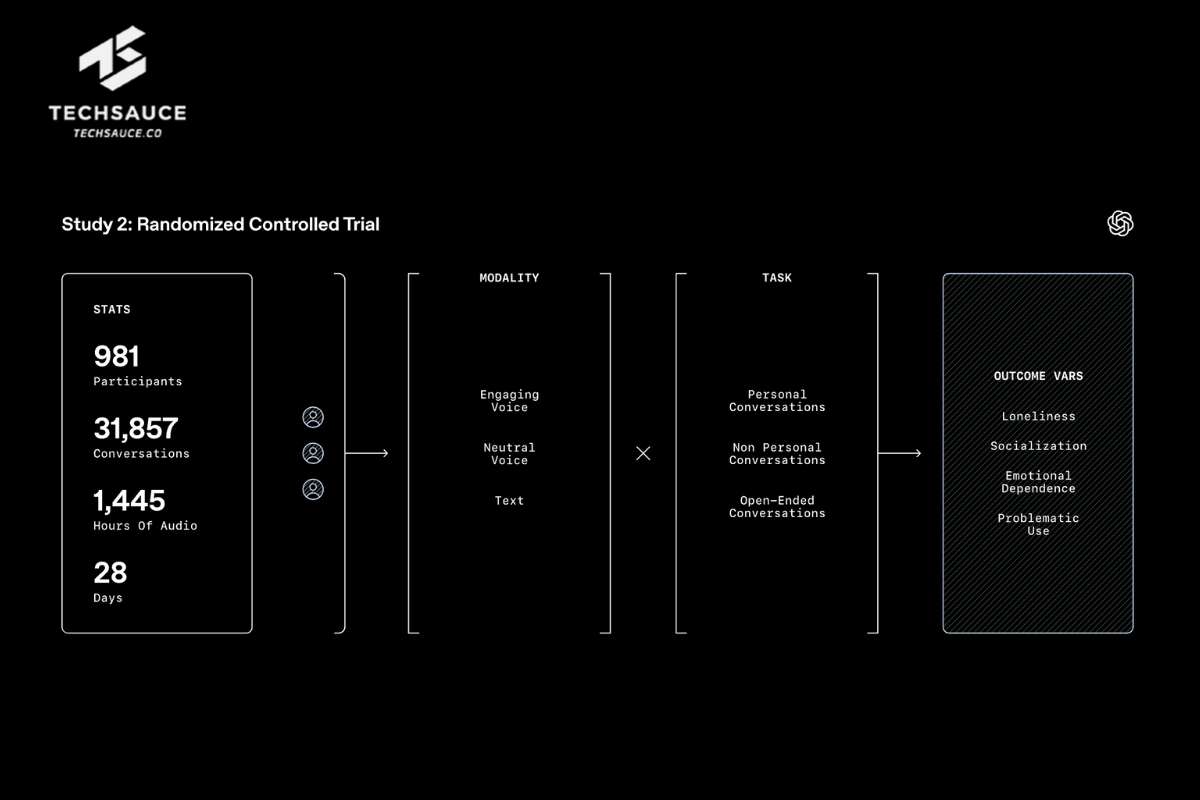

2.Randomized Controlled Trial

การทดลองนี้ชวนคนกว่า 1,000 คนมาลองใช้ ChatGPT เป็นเวลา 4 สัปดาห์โดยแบ่งคนเป็นกลุ่มๆ ให้ใช้ AI ในรูปแบบที่ต่างกัน เช่น ลองคุยแบบพิมพ์เพื่อเปรียบเทียบกับการใช้เสียง หรือลองคุยเรื่องส่วนตัวเพื่อเทียบกับเรื่องทั่วไป เพื่อดูว่าวิธีใช้จะส่งผลกระทบต่อความรู้สึกหรือไม่ เช่น ความเหงา การเจอเพื่อน การติด AI หรือการใช้ AI มากไป โดยมีวิธีการศึกษาดังนี้

รูปแบบการคุย

- เสียงน่าฟัง (Engaging voice)

- เสียงปกติ (Neutral voice)

- พิมพ์ข้อความ (Text)

ประเภทหัวข้อคุย

- คุยเรื่องส่วนตัว เช่น ช่วยคิดหน่อยว่าชีวิตนี้มีอะไรน่าขอบคุณบ้าง ?

- คุยเรื่องทั่วไป เช่น การ Work from home ทำให้บริษัททำงานดีขึ้นหรือแย่ลงกันแน่นะ ?

- คุยอะไรก็ได้ (Open-ended)

การทดลองนี้พบว่า การใช้เสียงคุยสั้นๆ ดูจะดีต่อสุขภาพใจ แต่ถ้าใช้ทุกวันเป็นเวลานาน กลับสัมพันธ์กับผลลัพธ์ที่แย่ลง (เช่น ความเหงาและการใช้ AI ที่เป็นปัญหามากขึ้น) อย่างไรก็ตาม เสียงที่ฟังดูน่าดึงดูดก็ไม่ได้ทำให้ผลแย่กว่าเสียงปกติหรือการพิมพ์ ที่น่าประหลาดใจคือ ในการทดลองนี้ คนที่พิมพ์คุยกลับแสดง สัญญาณเชิงอารมณ์ ที่ AI จับได้ มากกว่าคนที่ใช้เสียง

นอกจากนี้ ประเภทของหัวข้อที่คุยก็มีผล การทดลองพบว่า การคุยเรื่องส่วนตัว แม้จะสัมพันธ์กับความเหงาที่สูงขึ้นเล็กน้อย แต่กลับช่วยลดการติด AI หรือการใช้จนเป็นปัญหา ในทางตรงกันข้าม การคุยเรื่องทั่วไป" กลับมีแนวโน้มเพิ่มการพึ่งพาหรือติด AI โดยเฉพาะเมื่อใช้งานหนัก

งานวิจัยนี้บอกอะไร ?

งานวิจัยนี้บอกอะไรเรา? แม้จะเป็นเพียงก้าวแรกและมีข้อจำกัดอยู่บ้าง เช่น ศึกษาแค่ ChatGPT, เน้นภาษาอังกฤษ/บริบทอเมริกา, ยังไม่ผ่านการตรวจสอบเต็มรูปแบบ

แต่ผลการศึกษาก็ชี้ให้เห็นภาพที่ซับซ้อนว่า การคุยกับ AI อาจส่งผลต่อความรู้สึกและชีวิตเราได้จริง แต่จะดีหรือร้ายนั้นขึ้นอยู่กับหลายปัจจัย ทั้งตัวผู้ใช้ วิธีที่ใช้ว่าคุยเรื่องอะไร บ่อยแค่ไหน นานแค่ไหน

แต่สิ่งสำคัญคือ การใช้งานในระดับที่สูงหรือนานเกินไปดูจะเป็นปัจจัยเสี่ยงสำคัญ นี่จึงเป็นข้อมูลสำคัญสำหรับผู้พัฒนา AI ที่จะต้องคำนึงถึงการออกแบบอย่างมีความรับผิดชอบ เพื่อลดผลกระทบเชิงลบที่อาจเกิดขึ้นต่อสุขภาพใจของผู้ใช้ให้มากที่สุด

อ้างอิง : Investigating Affective Use and Emotional Well-being on ChatGPT

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด