สรุป AI อดีต ปัจจุบัน อนาคต โดย Eric Grimson ศาสตราจารย์จาก MIT

ภายในงาน MIT Bangkok Symposium - Unleashing AI: Transforming Industries, Empowering Futures ที่จัดขึ้นในกรุงเทพฯ ศาสตราจารย์ ดร. Eric Grimson (Prof. W. Eric L. Grimson) อธิการบดีฝ่ายวิชาการ จากสถาบันเทคโนโลยีแมสซาชูเซตส์ (MIT) ได้บรรยายพิเศษเพื่อเสนอมุมมองที่น่าสนใจของ AI ครอบคลุมตั้งแต่จุดเริ่มต้นในอดีต บทบาทสำคัญในปัจจุบัน และทิศทางอันน่าทึ่งในอนาคต AI แทรกซึมไปในทุกวงการ

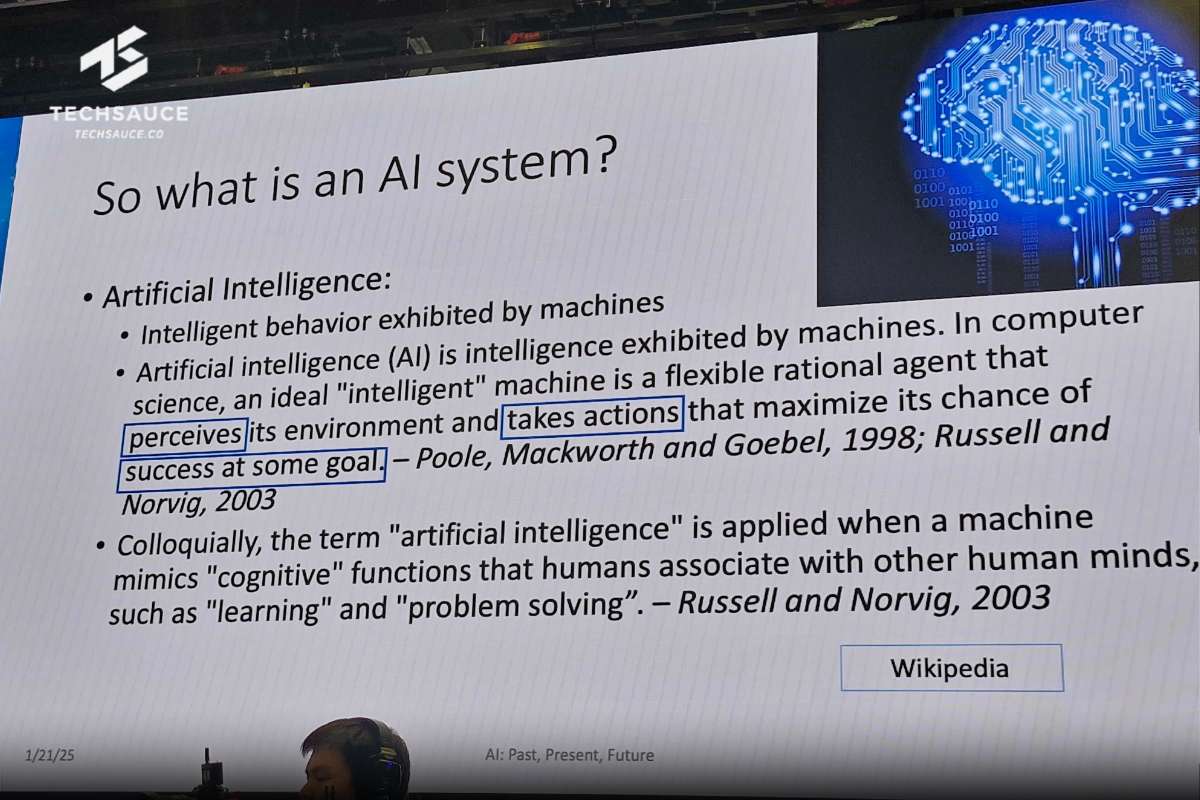

AI คืออะไรกัน… ?

นิยามของ AI คือ การที่เครื่องจักรแสดงออกถึงความฉลาด ในทางคอมพิวเตอร์แล้ว เครื่องจักรที่ฉลาดจริงๆ คือเครื่องที่คิดอย่างมีเหตุผล ปรับตัวเก่ง สามารถรับรู้และเข้าใจสภาพแวดล้อมรอบตัว และทำสิ่งต่างๆ เพื่อให้บรรลุเป้าหมายที่ตั้งไว้

โดยมนุษย์เรามักจะใช้คำว่า AI ในเวลาที่เครื่องจักรสามารถเลียนแบบความสามารถของสมองมนุษย์ได้ เช่น การเรียนรู้สิ่งใหม่ๆ หรือ การแก้ปัญหาต่างๆ

จากความหมายด้านต้น ศ.ดร.Eric Grimson เน้นย้ำให้เห็นถึงความสำคัญของ AI ทั้งหมด 3 ข้อนั่นคือ การรับรู้ (Perceive), Take Action (การกระทำ) และการบรรลุเป้าหมาย (Success at some goal)

ว่าแต่ที่ผ่านมา AI มาไกลแค่ไหน ?

ประวัติศาสตร์ย่อ AI ฉบับรวบรัด

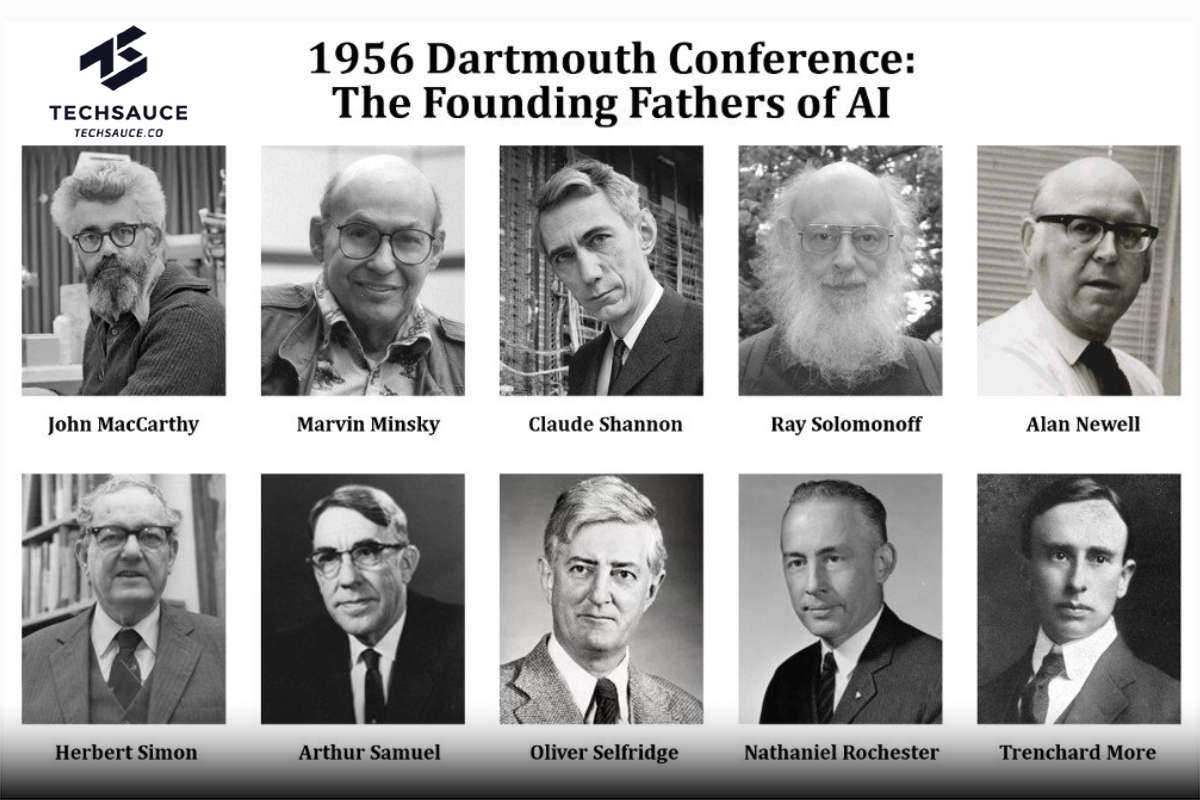

ศ.ดร.Eric Grimson เล่าว่าจุดเร่ิมต้นของ AI ต้องย้อนกลับไปในการประชุมเชิงปฏิบัติการที่ ดาร์ตเมาท์ (Dartmouth) เมื่อปี 1956 ที่ถูกยอมรับอย่างกว้างขวาง่าเป็นเหตุการณ์กำเนิดของ AI อย่างเป็นทางการ ที่น่าสนใจคือ 3 ใน 4 ของผู้จัดงานครั้งนั้นต่างเป็นคณาจารย์จาก MIT เอง ได้แก่ John McCarthy, Marvin Minsky และ Claude Shannon

ตอนนั้น John McCarthy มีความสนใจในการพัฒนาแนวคิดเครื่องจักรที่คิดได้ โดยตั้งชื่อว่า 'ปัญญาประดิษฐ์' สำหรับงานวิจัยสาขาดังกล่าว จึงได้จัดตั้งกลุ่มเพื่อนำเสนอทฤษฎีแนวคิด พร้อมหาความเป็นไปได้ในการพัฒนาเครื่องจักรที่สามารถใช้ภาษา ความคิด แก้ปัญหาต่างๆ ของมนุษย์

แต่เนื่องด้วยข้อจำกัดด้านเทคโนโลยีในยุคนั้น จึงทำให้งานที่ ดาร์ตเมาท์ เมื่อปี 1956 จบลงด้วยการพูดคุย และอภิปราย แต่ก็ถือว่าเป็นแนวคิดที่น่าสนใจ กระตุ้นความคิด และน่าตื่นเต้นสำหรับผู้ร่วมงานในครั้งนั้นเป็นอย่างมาก

ในช่วงยุคแรกของ AI จึงมุ่งเน้นไปที่การค้นหาวิธีการต่างๆ เพื่อบรรลุเป้าหมายที่กำหนดไว้ แต่แล้ววงการ AI ก็เจอกับด่านทดสอบแรกนั่นคือ ‘ฤดูหนาว AI’ (AI Winter) ในช่วงทศวรรษ 1970 เนื่องจากขาดแคลนเงินทุนสนับสนุน หลังถูกมองว่างานวิจัย AI ส่วนใหญ่ไม่น่าจะก่อให้เกิดสิ่งที่เป็นประโยชน์อนาคตอันใกล้

เงินทุนจากหน่วยงานในช่วงนั้นกลับถูกนำไปใช้กับโครงการที่จับต้องได้ เช่น รถถังอัตโนมัติ หรือเทคโนโลยีที่เกี่ยวกับการรบ

ต่อมาในช่วงปี 1980 เป็นยุคของคลื่นลูกที่สองของ AI เกิดการพัฒนาสิ่งใหม่ในวงการที่มีชื่อเรียกว่า 'Expert System' โดยเป็นระบบคอมพิวเตอร์ที่จำลองความสามารถในการตัดสินใจของผู้เชี่ยวชาญที่เป็นมนุษย์ และถูกนำไปใช้ในเชิงพาณิชย์อย่างกว้างขวาง

แม้จะประสบความสำเร็จในช่วงแรก แต่ Expert System กลับไปได้ไม่สวยนัก ด้วยเหตุผลด้านค่าใช้จ่ายด้านการรักษาที่สูงมาก แก้ไขเพิ่มเติมข้อมูลในระบบยาก มีข้อจำกัดทางตรรกะ และที่สำคัญระบบนั้นไม่สามารถเรียนรู้สิ่งใหม่ๆ หรือปรับปรุงตัวเองจากข้อมูลใหม่ที่ได้รับไป นำไปสู่ฤดูหนาว AI ครั้งที่สอง

AI วันนี้เป็นอย่างไร ?

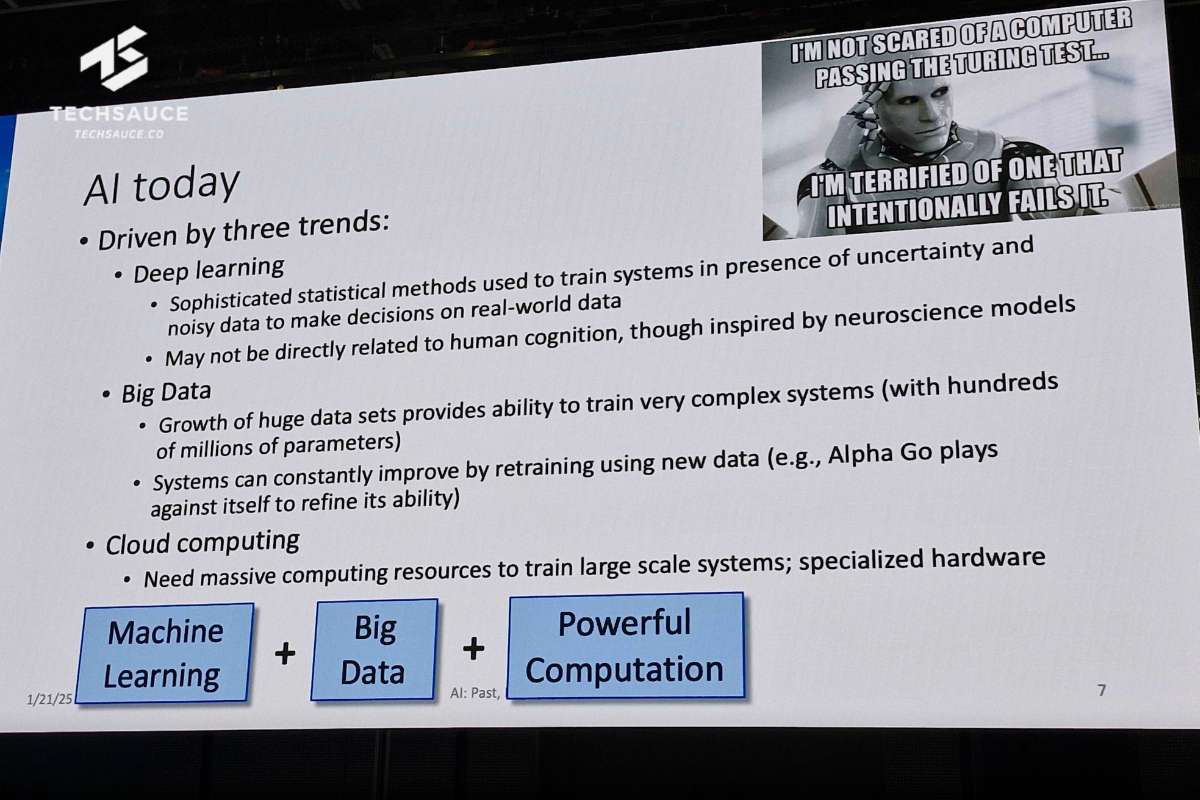

ตัดภาพมาที่ปัจจุบัน ศ.ดร.Eric Grimson บอกว่าเราได้เข้าสู่ยุคที่สาม AI แล้ว โดยมีสามสิ่งที่ขับเคลื่อนความก้าวหน้า ได้แก่

- Deep Learning : เทคนิคการสอนคอมพิวเตอร์ให้คิดและตัดสินใจได้ดีขึ้น แม้ในสถานการณ์ที่ซับซ้อน

- Big Data : การมีข้อมูลจำนวนมหาศาลให้คอมพิวเตอร์ได้เรียนรู้

- Cloud Computing : การมีคอมพิวเตอร์ที่แรงมากพอที่จะรองรับการเรียนรู้ของ AI

AI ส่วนใหญ่ในปัจจุบันเป็น Machine Learning

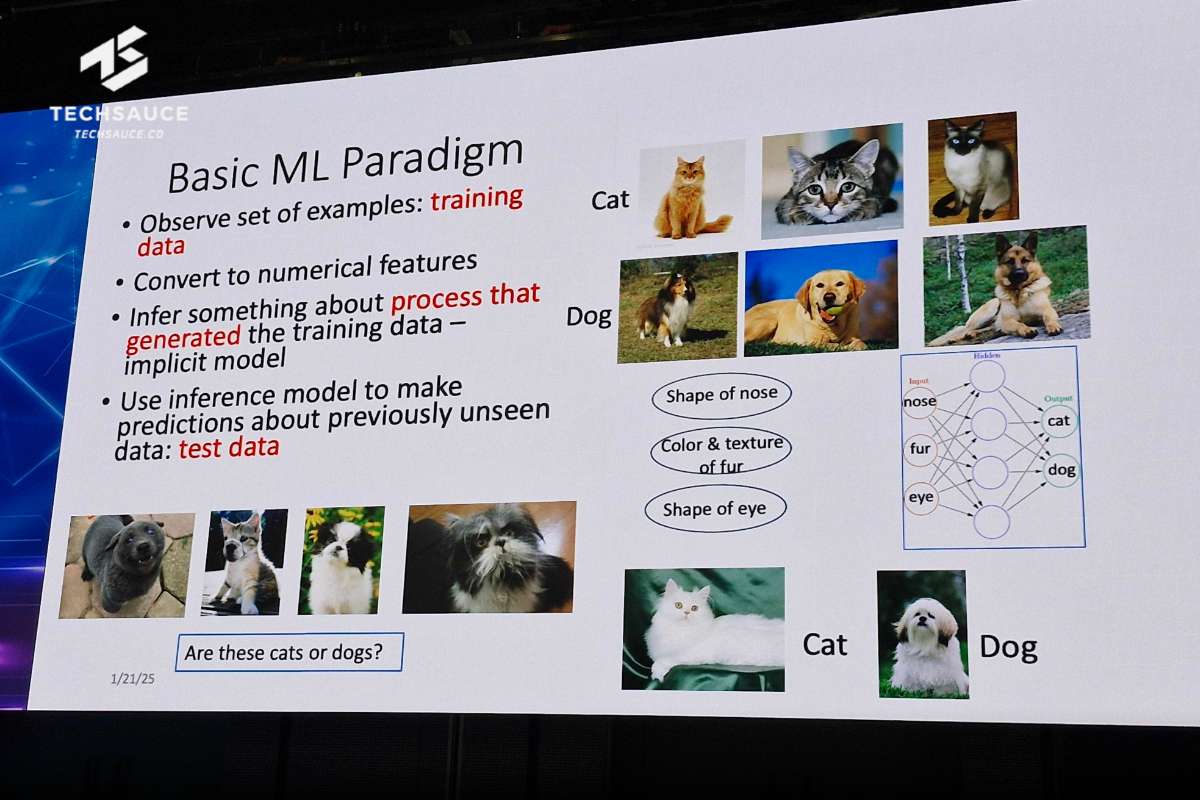

ศ.ดร.Eric Grimson เล่าต่อว่า คอมพิวเตอร์สามารถเรียนรู้ได้โดยไม่ต้องถูกตั้งโปรแกรมไว้อย่างชัดเจน ผ่านการวิเคราะห์ข้อมูลจำนวนมหาศาล ตัวอย่างเช่น การแยกแยะรูปภาพแมวกับสุนัขโดยให้ AI เรียนรู้จากภาพจำนวนมาก

หลักการทำงานของ Machine Learning แบบคร่าวๆ มีอยู่ 3 สเต็ปคือ ดูตัวอย่าง, หาจุดร่วม และทดสอบความรู้

ดูตัวอย่าง: ให้คอมพิวเตอร์ดูรูปภาพข้อมูลฝึกฝนเยอะๆ เช่น รูปแมวหลายๆ พันรูป

หาจุดร่วม: คอมพิวเตอร์จะพยายามสังเกต และจับจุดร่วมของรูปแมวทั้งหมด เช่น แมวมีตา มีหู มีขน แล้วสร้างเป็นกฎในใจ

ทดสอบความรู้: จากนั้นรูปแมวรูปใหม่ที่คอมพิวเตอร์ไม่เคยเห็นมาก่อน (test data) มาทดสอบดูว่ามันทายถูกหรือไม่

และ Machine Learning ก็สามารถแยกย่อยออกไปได้ 2 แบบหลักๆ คือ

1.แบบมีคนสอน (Supervised Learning)

นึกภาพว่าเราสอนเด็กคนหนึ่งโดยใช้วิธีบอกคำตอบ (การติด label) ที่ถูกต้องไปด้วย เช่น เอารูปแมวให้ดูแล้วบอกว่าสิ่งนี้คือแมว เอารูปสุนัขให้ดูแล้วบอกว่าสิ่งนี้คือหมา ทำแบบนี้ซ้ำๆ คอมพิวเตอร์ก็จะเริ่มเรียนรู้ความแตกต่างระหว่างหมากับแมว และสามารถแยกแยะได้เอง

2.แบบไม่มีคนสอน (Unsupervised Learning)

นึกภาพเราสอนเด็กให้เรียนรู้การจัดกลุ่มโดยโยนของเล่นหลายๆ ชิ้นโดยไม่บอกว่าคืออะไร (ไม่ติด label) เด็กจะต้องพยายามสังเกต และจัดกลุ่มของเล่นที่มีลักษณะคล้ายๆ กันด้วยตัวเองเช่น รูปทรง สี ขนาด สิ่งนี้ในทาง Machine Learning เรียกว่า Natural Clusters (การจัดกลุ่มข้อมูลด้วยตัวเองโดยธรรมชาติ)

การประยุกต์ใช้ AI ในปัจจุบัน และอนาคต

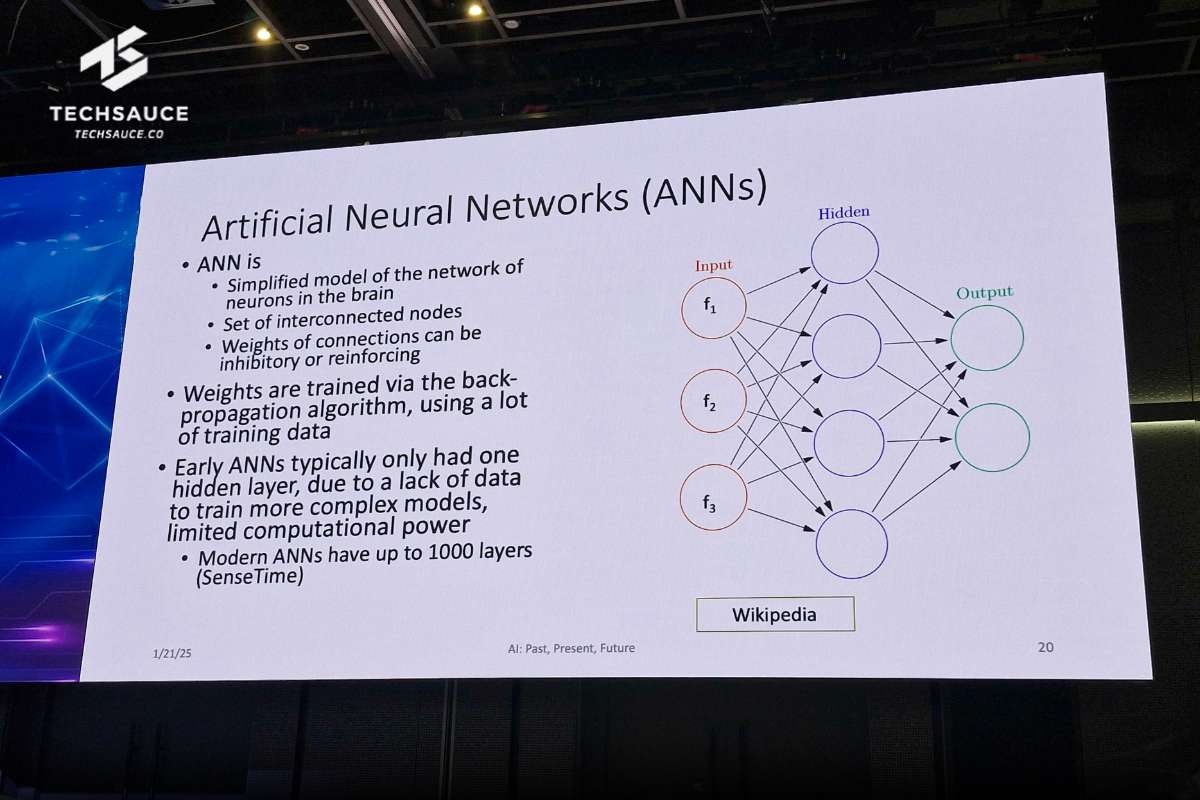

การที่จะทำให้ AI เรียนรู้สิ่งที่ซับซ้อน ก็จำเป็นต้องสร้างสมองให้ AI สิ่งนี้เรียกว่า Artificial Neural Networks หรือ ANNs แบบจำลองทางคณิตศาสตร์ที่ได้รับแรงบันดาลใจจากความรู้ด้านประสาทวิทยา (Neurophysiology) ซึ่งนับเป็นรากฐานสำคัญของ AI ในยุคใหม่ ซึ่งหนึ่งในนั้นก็คือ LLMs

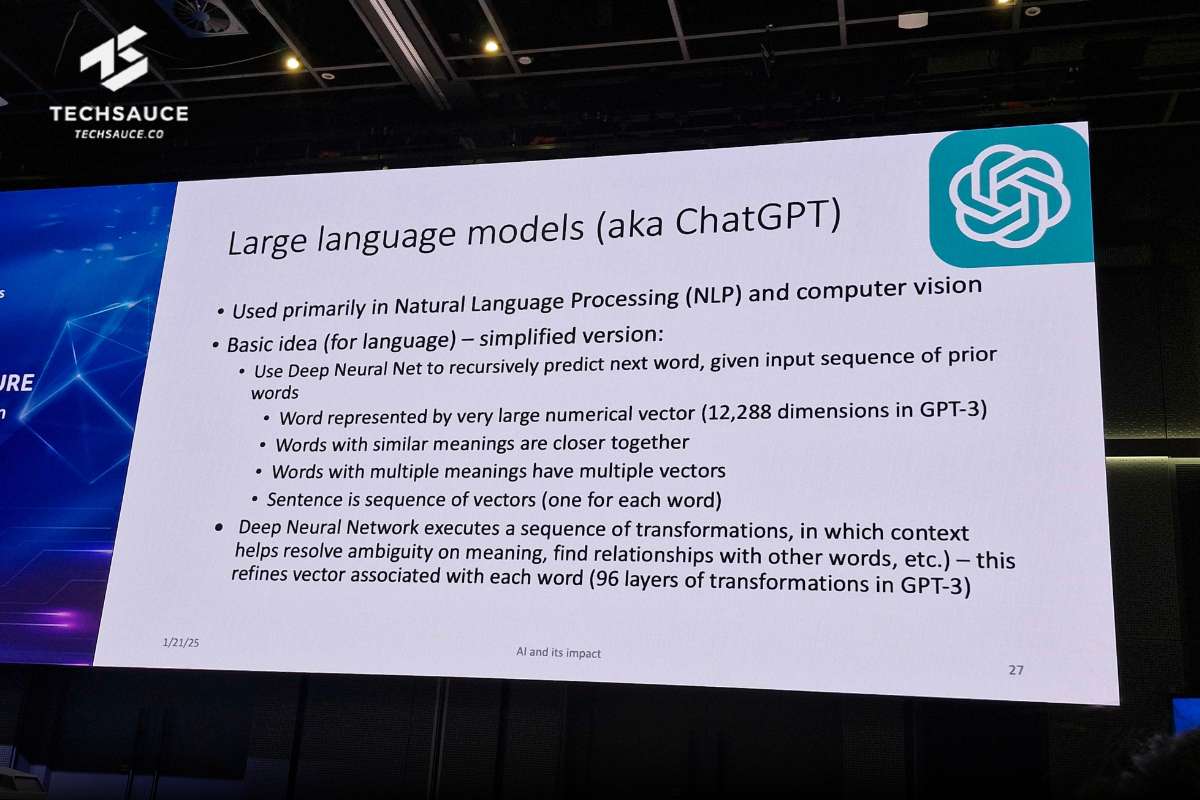

Large Language Models (LLMs) พูดง่ายๆ ก็คือ โปรแกรมคอมพิวเตอร์อัจฉริยะที่เก่งภาษา โปรแกรมเหล่านี้สร้างขึ้นจากโครงข่ายประสาทเทียมเชิงลึก (Deep Neural Net) ทำให้สามารถเข้าใจและสร้างข้อความที่เหมือนกับมนุษย์เขียนได้อย่างน่าทึ่ง

ตัวอย่างที่โด่งดังของ LLMs ก็คือ GPT (Generative Pre-trained Transformer) ของบริษัท OpenAI ซึ่งได้รับการฝึกฝนด้วยประโยคจำนวนมหาศาลกว่า 30,000 ล้านประโยค โดยใช้การ ‘คาดเดา’ คำถัดไปว่าน่าจะเป็นอะไร และแปลงเป็นประโยคตามบริบทที่ผู้ใช้ถาม

แต่ GPT ไม่ได้เพียงแค่เดาคำถัดไป แต่ใช้โครงข่ายประสาทเทียมเชิงลึก (Deep Neural Net) ที่มีกระบวนการแปลง (transformations) หลายชั้น (ใน GPT-3 มีถึง 96 ชั้น) เพื่อวิเคราะห์และปรับแต่งความหมายของแต่ละคำในประโยค โดยคำนึงถึงบริบทและความหมายของคำใกล้เคียง ผลลัพธ์ที่ได้คือความสามารถในการเข้าใจและสร้างข้อความที่สอดคล้องและเป็นธรรมชาติอย่างน่าทึ่ง

พูดง่ายๆ คือ โลกเรามีเครื่องจักรที่พูดคุย และใช้ภาษาได้ราวกับมนุษย์เหมือนกับที่กลุ่มผู้บุกเบิกในปี 1956 วาดฝันไว้เป็นที่เรียบร้อย

ตัวอย่างความสำเร็จของ AI ในยุคปัจจุบัน

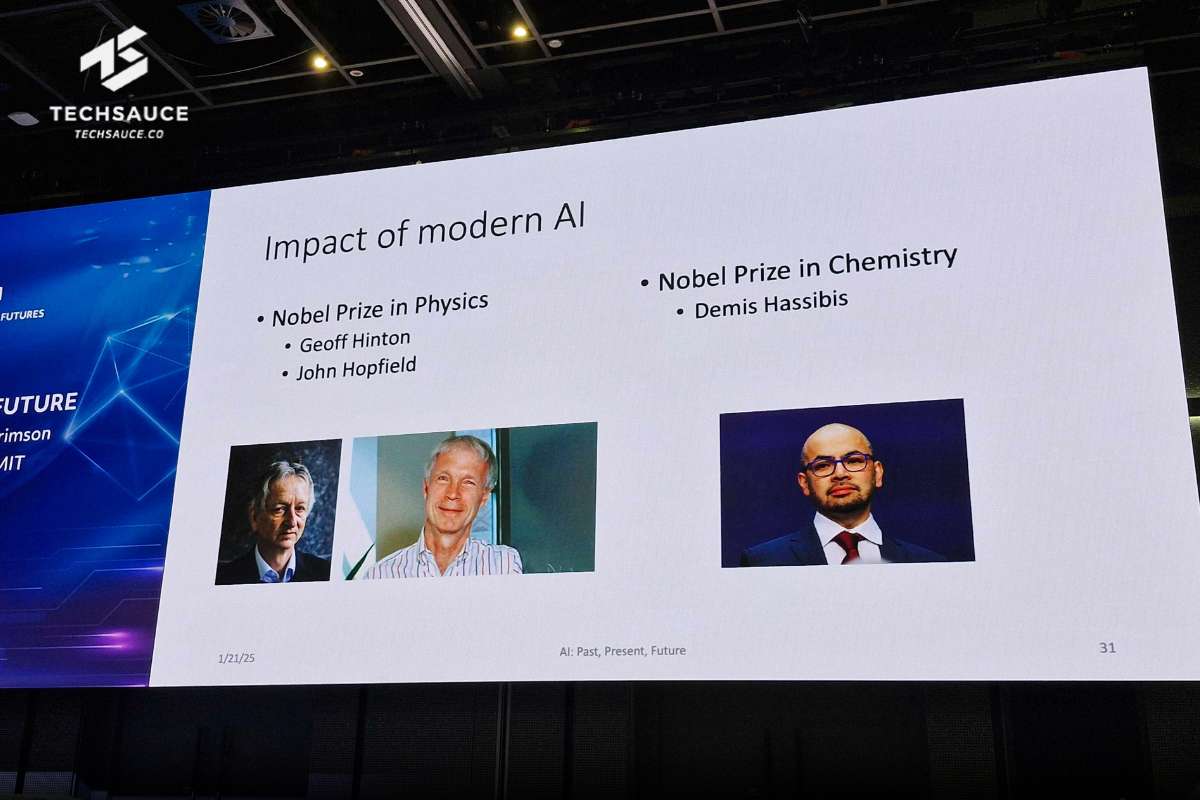

- ช่วยนักวิจัยค้นพบในสาขาฟิสิกข์ และเคมี จนได้รับรางวัลโนเบล

- ช่วยค้นพบยาปฏิชีวนะใหม่ ตรวจหามะเร็งเต้านม

- การวิเคราะห์ตรวจสอบอาการผู้ป่วยทางไกล

- การรับรู้จดจำเสียงพูด โต้ตอบ และแปลภาษาในหลายอุปกรณ์ เช่น Siri, Amazon Echo, Google Translate

- การมองเห็น (Vision) นำไปสู่การจดจำใบหน้า, การตรวจสอบลายมือบนเช็ก ไปจนถึงการวิเคราะห์สภาพแวดล้อมบนถนนสำหรับระบบไร้คนขับ

- หุ่นยนต์ ไม่ว่าจะเป็น หุ่นยนต์ขับเคลื่อนด้วยตนเอง หุ่นยนต์แขนกลในโรงงาน หุ่นยนต์ดูดฝุ่นในบ้าน ไปจนถึงหุ่นยนต์ในภาคการเกษตร

- การวิจัยในสาขาอื่นๆ เช่น การสร้างโค้ด การพิมพ์ 3 มิติ การประมวลผลการได้ยินของมนุษย์ เป็นต้น

ส่วนทางฝั่ง MIT เอง จากที่เคยเป็นผู้บุกเบิก AI ในวันนี้กำลังมีบทบาทสำคัญในการพัฒนา AI มาอย่างต่อเนื่อง มุ่งเน้นไปที่การบูรณาการ AI และ Machine Learning เข้ากับทุกสาขาวิชาทั้งในด้านการศึกษาและการวิจัย

อย่างไรก็ตาม AI ในอนาคตยังเผชิญทั้งความท้าทายและโอกาส โดยเฉพาะอย่างยิ่งความต้องการทรัพยากรข้อมูลและพลังการประมวลผลที่เพิ่มขึ้น นอกจากนี้ ยังมีความสำคัญในด้านจริยธรรมและการกำกับดูแล AI รวมถึงการพัฒนา AI ในสาขาเฉพาะทางที่จะแซงหน้ามนุษย์ในไม่ช้า เช่น ระบบจดจำใบหน้าและยานยานยนต์ไร้คนขับ

AI มีศักยภาพสูงมาก แต่ก็ต้องพัฒนาควบคู่ไปกับความรับผิดชอบ

อ้างอิง : งาน MIT Bangkok Symposium - Unleashing AI: Transforming Industries, Empowering Futures

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด