สาวเอเชียถูก AI เหยียดเชื้อชาติ ใช้ปรับรูปถ่ายให้ดูมืออาชีพ แต่เปลี่ยนเธอเป็นฝรั่งตาฟ้า

นักศึกษาหญิงชาวเอเชียถูก AI เหยียดเชื้อชาติ เปลี่ยนรูปสมัครงานเป็นหน้าฝรั่ง ซึ่งเป็นจุดบอดที่ทำลายความน่าเชื่อถือของเทคโนโลยีนี้ และยังแก้ไม่ได้

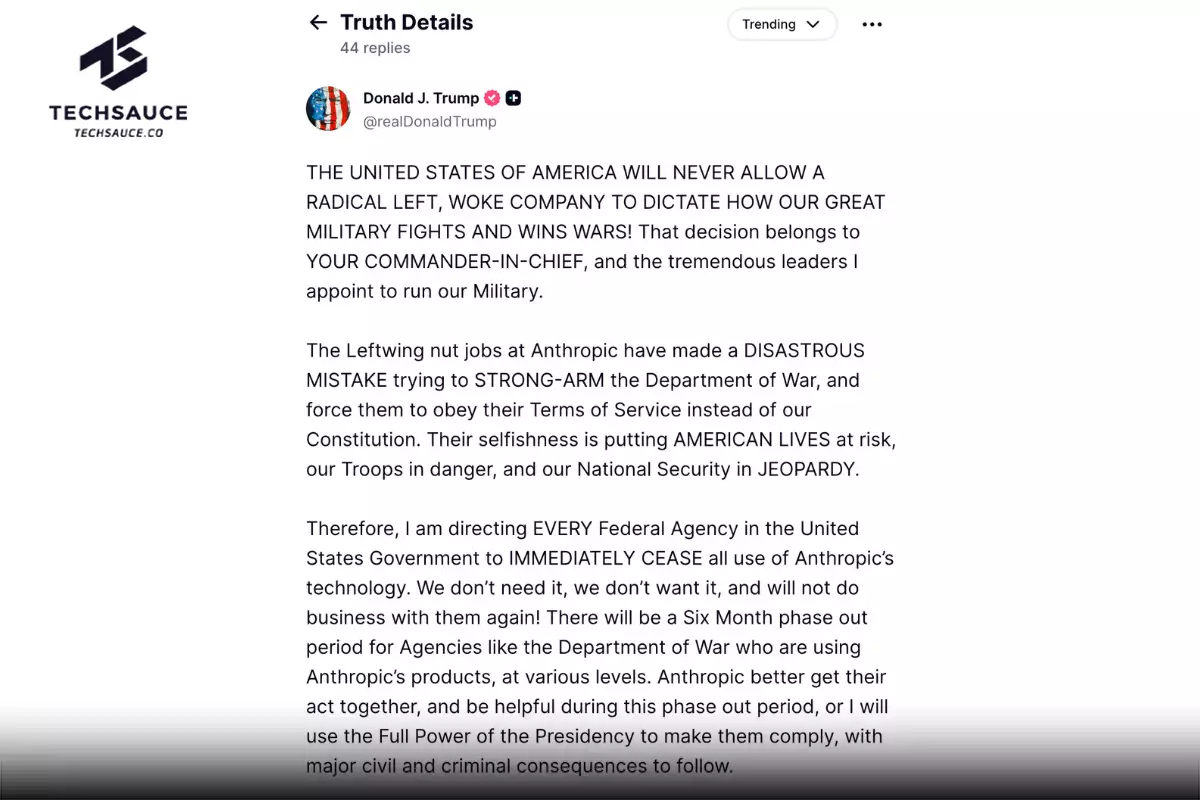

Image Caption

Image Caption

อคติแฝงจาก AI ที่เกิดกับนักศึกษาชาวเอเชีย

Rona Wang นักศึกษาชาวอเมริกันเชื้อสายเอเชียจาก MIT ใช้เครื่องมือ Playground AI เพื่อปรับแต่งรูปถ่ายของเธอให้ดูเป็น ‘มืออาชีพมากขึ้น’ เพราะต้องการนำไปใช้เป็นรูปโปรไฟล์ใน LinkedIn แต่สิ่งที่ทำให้เธอประหลาดใจ คือ AI ปรับเปลี่ยนสัญชาติของเธอจากชาวเอเชียกลายเป็นฝรั่งตาน้ำข้าว

รูปจาก: Twitter @ronawang

รูปจาก: Twitter @ronawang

มันปรับให้สีผิวของ Wang ให้สว่างขึ้นพร้อมกับเปลี่ยนสีตาของเธอให้กลายเป็นสีฟ้า Wang จึงนำภาพที่ AI ปรับแต่งให้มาแชร์บน Twitter ในตอนแรกเธอมองว่ามันตลกดี แต่พอคิดดูดี ๆ AI ที่เธอใช้มีอคติทางเชื้อชาติแฝงอยู่

เห็นได้ชัดว่า AI ตัวนี้ตัดสินว่าคนขาวเท่านั้นที่มีความเป็นมืออาชีพ ซึ่งเป็นเรื่องที่น่ากังวลหากมีบริษัทที่ใช้ AI ในการเลือกผู้สมัคร AI bias คงเป็นปัญหาใหญ่และไม่ยุติธรรมกับผู้สมัครเชื้อชาติอื่นแน่ ๆ

AI มันเหยียดเชื้อชาติได้ยังไง ?

จากเหตุการณ์ที่เกิดขึ้นกับ Rona Wang คุณอาจสงสัยว่า AI มันเหยียดเชื้อชาติได้ยังไง ?

สิ่งที่ AI ตัวนี้แสดงออกมา เรียกว่า AI bias หรืออคติของ AI เกิดจากการที่มันถูกสอนด้วยข้อมูลที่ไม่ถูกต้องหรือไม่สมบูรณ์ และบางครั้งผู้ฝึกอบรม AI ใส่อคติของตัวเองป้อนลงใน Machine learning (สมองของ AI) ส่งผลให้การตัดสินใจของอัลกอริทึมเกิดอคติหรือความไม่เป็นธรรม ซึ่งเมื่อ AI แสดงผลออกมา ผลลัพธ์จึงไม่เป็นกลางและมีอคติแฝงอยู่

AI Bias มีกี่ประเภท

การป้อนข้อมูลที่ไม่ถูกต้องหรือไม่สมบูรณ์ทำให้เราสามารถแยก AI Bias ได้ออกเป็น 7 ประเภท ดังนี้

- Algorithm bias: อคติที่เกิดจากปัญหาภายในอัลกอริทึม เช่น ชุดการคำนวณทำงานผิดพลาด ซึ่งทำให้ Machine learning จดจำข้อผิดพลาดและประมวลผลลัพธ์ออกมามีอคติ

- Sample bias: อคติที่เกิดจากข้อมูลตัวอย่างที่นำมาสอน AI ไม่กว้างพอ หรือไม่ครอบคลุม ทำให้ AI ไม่เห็นถึงสิ่งที่เราต้องการให้มันเรียนรู้ทั้งหมด เช่น ต้องการให้มันเรียนรู้เกี่ยวกับครู แต่ข้อมูลตัวอย่างที่นำมาสอนมีแต่ครูที่เป็นผู้หญิง ระบบก็อาจจะเรียนรู้ว่า ครูทุกคนต้องเป็นผู้หญิงเพราะมันไม่เคยเห็นครูผู้ชาย

- Prejudice bias: อคติที่เกิดจากความเชื่อผิด ๆ ที่มีอยู่เดิม เช่น ผู้ชายต้องเป็นหมอและผู้หญิงต้องเป็นพยาบาล

- Measurement bias: อคติที่เกิดจากวิธีการวัดและประเมินผลที่ใช้สอน AI อาจจะไม่ถูกต้องครบถ้วน เช่น อยากสอนให้มันรู้จักกับคนที่มีความสุข และสอนมันด้วยภาพคนที่ยิ้มแย้ม AI ก็จะคิดว่าทุกคนที่ยิ้มคือคนที่มีความสุข ซึ่งความจริงอาจจะไม่ได้เป็นแบบนั้นเสมอไป

- Exclusion bias: อคติที่เกิดจากความไม่รู้ของผู้พัฒนาเรื่องการใช้ข้อมูลในการสอน AI เช่น ไม่ได้ป้อนข้อมูลสำคัญที่มีผลต่อการตัดสินใจ เพราะไม่รู้ว่าข้อมูลที่ขาดหายไปนี้มีความสำคัญ

- Selection bias: อคติที่เกิดจากข้อมูลที่ใช้ในการฝึกไม่กว้างพอ จึงทำให้ผลลัพธ์ไม่แม่นยำและผิดพลาด เช่น การฝึกให้ AI รู้จักสัตว์ แต่ฝึกด้วยหมา แมว และนก ซึ่งทำให้ AI ไม่เข้าใจสัตว์ชนิดอื่น ๆ

- Recall bias: อคติที่เกิดจากความคิดเห็นหรือความเข้าใจที่แตกต่างกัน เช่น มีขนมอยู่ชนิดหนึ่ง คนหนึ่งเรียกขนมชนิดนี้ว่า A แต่อีก 7 คนเรียกขนมชนิดนี้ว่า B เพราะมีความคิดความเข้าใจที่แตกต่าง การนำข้อมูลเหล่านี้ไปป้อนให้ AI จึงอาจทำให้มันสับสนได้

อ้างอิง : businessinsider, techtarget

ลงทะเบียนเข้าสู่ระบบ เพื่ออ่านบทความฟรีไม่จำกัด